Lo que comenzó con computadoras enfrentando a campeones del ajedrez se convirtió en una revolución tecnológica: desde vehículos que circulan sin conductor y asistentes virtuales hasta programas que deciden operaciones financieras. Los algoritmos y el futuro del trabajo.

25 de julio de 2018

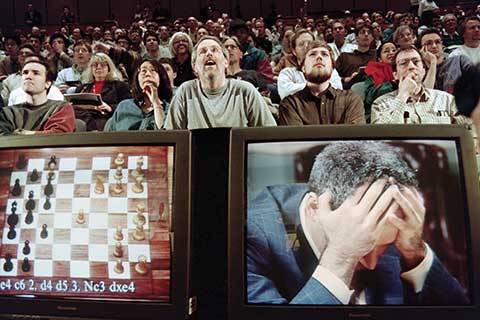

El 10 de febrero de 1996, por primera vez en la historia, una máquina le ganó una partida de ajedrez en un tiempo estándar a un campeón mundial vigente, el ruso Gary Kasparov. Deep Blue, así se llamaba la computadora, había sido fabricada por IBM y con ella salía a la escena pública una nueva vedette de la informática: la inteligencia artificial.

Rápidamente, no sin razón, se criticó el uso de la palabrita inteligencia para definir a Deep Blue, una máquina que, lejos de entender el juego, realizaba un procesamiento paralelo masivo de miles de partidas anteriores y de allí elegía las mejores movidas. Por decirlo de otra manera, no había ganado tanto la maña como la fuerza bruta computacional.

Sin embargo, se trataba de un comienzo promisorio, y poco tiempo después, las computadoras comenzaron a ganarle fácil a cualquier gran maestro. Pero el método tenía límites cuando debía actuar en sistemas de alternativas infinitas, como el lenguaje o el Go, un juego chino con tal cantidad de opciones que ningún sistema podía procesarlas en su totalidad. Como suele ocurrir, ese comienzo explosivo se amesetó después de un tiempo, al no poder superar los nuevos escollos sin un cambio de paradigma.

«Si me preguntabas hace quince años sobre los éxitos de la inteligencia artificial en procesamiento del lenguaje natural, ya sea en español, inglés o suajili, te contestaba que estábamos en pañales», explica Agustín Gravano, especialista en Inteligencia Artificial e investigador del Consejo Nacional de Investigaciones Científicas y Técnicas (CONICET). «El reconocimiento de palabras funcionaba mal; entenderlas, usarlas como las usamos los seres humanos, se lograba de forma muy limitada».

Como los niños

El gran salto llegó en el siglo XXI, cuando se revolucionaron las técnicas ya conocidas de machine learning o aprendizaje automático. Estos sistemas proponen que la computadora aprenda: para ello se le brindan muchos datos, enormes cantidades, y ella misma empieza a buscar patrones que le permitan luego analizar casos nuevos y etiquetarlos con eficiencia. De alguna manera, estos sistemas reproducen el comportamiento de los niños que preguntan «¿esto qué es?» una y otra vez, pero lo hacen en una porción muy menor de tiempo. Así aprenden por inducción a diferenciar una manzana de un tomate: por prueba y error (muchas pruebas y errores) desarrollan algoritmos (una secuencia de pasos y reglas) para saber qué tipo de fruto rojo está «viendo». Este modelo pudo mostrar su verdadero potencial en el siglo XXI con procesadores más poderosos.

El método estrella del aprendizaje automático es el deep learning o aprendizaje profundo: «Ese sistema se inspira, muy a grandes rasgos, en el cerebro humano», continúa Gravano en su oficina de la Facultad de Ciencias Exactas y Naturales de la Universidad de Buenos Aires (UBA), donde da clases. «Lo que hace es reproducir el modelo de conexiones entre neuronas: cuando frente a determinados estímulos observás que se activa una respuesta correcta, reforzás esos caminos; en cambio, si la respuesta está mal, los penalizás». Este tipo de sistemas mejora con la práctica y, sobre todo, con la supervisión. Si se le indica una y otra vez cuándo está haciendo las cosas bien, su precisión mejora. Paradójicamente, para esa tarea es necesario un ser humano: ¿de dónde sacar esa cantidad de trabajo consciente que guíe a las máquinas?

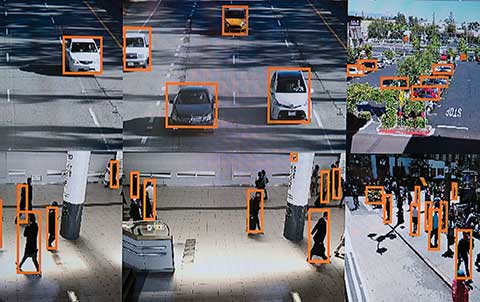

Hay muchas formas: por ejemplo, cuando millones de seres humanos cada día llenan Captchas e indican dónde hay un auto o qué número se ve en una foto. También, cuando alguien acompaña una frase con un emoticón, el sistema asocia secuencias de palabras con estados de ánimo. Al indicar qué posteo gusta, encanta, divierte, entristece, etcétera, permitimos al algoritmo saber más de nuestros intereses y estados de ánimo para entretenernos u ofrecernos el producto que podemos llegar a comprar. El buscador de Google aprende qué busca la gente con sus millones de preguntas y cuáles son las respuestas más elegidas según quién busca. En resumen, sin el ingrediente del esforzado trabajo inconsciente de millones de personas cada día, la tarea de educar a los algoritmos habría resultado mucho más difícil.

El aprendizaje profundo despegó cerca de 2009, cuando se comprendió cómo hacerlo crecer: «Las redes neuronales profundas tienen muchas capas de neuronas. Cada neurona es un nodo en una red que recibe datos, los procesa y emite datos que van a parar a otras», explica Gravano, didáctico. Tal vez lo más interesante sea que los algoritmos que desarrollan las propias máquinas se han vuelto tan complejos que ni siquiera sus creadores logran saber realmente cómo funcionan.

Contra todo lo que se decía dos décadas atrás, el 9 de marzo de 2016 una computadora de Google venció al campeón mundial de Go. Pero su potencial dejó de ser una mera anécdota lúdica para expandirse a casi todos los terrenos.

Rebeldía en Google

A principios de abril último, más de 4.000 empleados de Google firmaron una carta de protesta: la corporación estaba colaborando con el Pentágono en el proyecto de inteligencia artificial «Maven», cuyo objetivo es interpretar imágenes durante los ataques de drones. «Creemos que Google no debería entrar en el negocio de la guerra», comienza la carta. El vínculo de la corporación con el aparato de Defensa es conocido, pero esta es la primera protesta masiva interna en la empresa cuyo lema es: «No seas malvado». Google contestó que la tecnología no se usaría para producir armas autónomas, sino para reducir el número de víctimas civiles y otros daños colaterales. Cerca de una docena de ingenieros renunció al poco tiempo.

«Hay un debate ético fuerte dentro de la comunidad: todos tenemos presente a Terminator, con las máquinas tomando consciencia de su propia existencia», resume Gravano. «Pero no hace falta llegar a la consciencia para que pase algo peligroso: hoy en día hay máquinas que bombardean solas. Ya hace años que se busca automatizar la toma de decisiones».

El ejemplo puede ser extremo, pero dista de ser único: los autos que se manejan solos ya pueden circular en varios estados de Estados Unidos. Si el algoritmo que conduce un auto tuviera que decidir entre esquivar a un niño o caer con el conductor por un precipicio, ¿qué debería hacer? ¿Quién sería responsable de esa decisión?

El matemático y director del área de Ciencias de Datos de la Fundación Sadosky, Leandro Lombardi, coincide en que el mayor peligro no es una hipotética revolución de las máquinas: «La verdadera preocupación debería ser qué pasará con el trabajo. En EE.UU. calculan que unos dos millones de choferes de camiones podrían perder el trabajo. Hay varios millones más de puestos en call centers que podrían automatizarse. ¿Qué hacemos con esa gente? Hay quienes dicen que debería haber un salario universal para que la gente lo aproveche para capacitarse más y poder tomar los nuevos empleos que surjan». De alguna manera, es la utopía original del desarrollo tecnológico: máquinas haciendo el trabajo mientras los hombres se dedican al ocio o las artes. Por ahora el sistema político y económico no parece ir hacia ese lado.

«Hay también formas más sutiles en que la inteligencia artificial nos afecta: mi mujer una vez hizo un clic en una nota de Maru Botana», sigue Lombardi. «Después siguió un poco el tema y, luego, en el servicio de noticias de Android, siempre le aparecían notas sobre ella. Después de un tiempo, para su celular, parecía que lo único que pasaba en el mundo era lo que hacía Maru Botana y algunas cosas más. Mucha gente no es consciente de la burbuja que crean los algoritmos que buscan engancharnos sobre la base de lo que nos interesó».

Los algoritmos también son muy utilizados para responder rápidamente a los cambios en la bolsa y obtener algunos dólares por segundo. Este tipo de actividad bursátil de Alta Frecuencia, como se la llama, aprende la mejor forma de multiplicar las ganancias realizando miles de transacciones por segundo. El 6 de mayo de 2010 se produjo una quiebra rápida o «flash crash» cuando los algoritmos intervinientes se retroalimentaron a una velocidad pasmosa. Como ya no se sabe qué hacen lo algoritmos, aún no se comprende exactamente qué pasó.

Herramientas autónomas

Autos, guerra, finanzas, noticias… la lista sigue y plantea preguntas serias acerca de cuánto control se pierde sobre las herramientas a cambio de una supuesta eficiencia. «Se ha producido un cambio tecnológico muy fuerte y no se lo puede dejar liberado al mercado para que lo resuelva sobre la base de incentivos económicos», se preocupa Lombardi. «Ya lo vimos en el mercado de capitale, que está explotado algorítmicamente. Es un mercado que, si no se regula, pierde la razón para la que se concibió». Justamente, el programa de Ciencia de Datos de la Fundación Sadosky, que depende del Ministerio de Ciencia, Tecnología e Innovación Productiva, busca desarrollar el área de ciencias de datos a través de asesoramiento, educación y difusión. Particularmente, asesora al Estado intentando fundamentar con rigor científico las políticas públicas.

Un ejemplo de lo que no se debe hacer en ese sentido lo dio el gobernador de Salta, Juan Manuel Urtubey, quien recientemente aseguró que por medio de la inteligencia artificial se podía predecir con nombre y apellido qué adolescentes quedarían embarazadas (ver Prejuicios y datos).

Una de las formas en las que el potencial del aprendizaje automático llegó al gran público son los asistentes virtuales, como Cortana, Siri o Alexa, capaces de comprender órdenes relativamente complejas. Más recientemente, se han logrado sorprendentes imitaciones del lenguaje natural: en mayo último Google presentó su nuevo servicio, Duplex, capaz de automatizar llamadas para reservar un turno en una peluquería o un restaurante (el video se puede ver en YouTube). El sistema incluso emite interjecciones para indicar a su interlocutor humano que está esperando. «Antes tenías un montón de gente tratando de entender las reglas del lenguaje: ahora tenés a las máquinas armando sus propios algoritmos. De hecho, es muy poco lo que sabemos de cómo se codifica ahí adentro: hay algunos algoritmos sobre los que no tenemos idea de qué están haciendo», explica Gravano, cuya área de investigación específica es el lenguaje natural (ver Identificación de emociones).

¿Se puede empezar a hablar de inteligencia con todas las letras? «¿Era inteligente Deep Blue?», se pregunta Gravano. «Había un consenso de que no, no era inteligente. Ahora hay una discusión similar con esto: ¿simplemente es fuerza bruta de la mejor combinación? ¿Entonces, qué somos nosotros? Porque vemos que hay mucha analogía entre las redes artificiales y las naturales, donde también hay una combinación de millones de nodos/neuronas».

Al fin y al cabo, procesos que realizamos los humanos, como el habla o el reconocimiento de imágenes, se basan en numerosas experiencias anteriores asimiladas. El razonamiento deductivo es casi una rareza en la cotidianidad. Edgar Altszyler, doctor en Física y miembro del equipo de la Fundación Sadosky, parece convencido: «Si aceptamos que estamos condicionados por nuestra materialidad, ¿por qué no podríamos pensar que nuestro cerebro también es un montón de nodos interactuando y aprendiendo permanentemente?». «Ahí ya entramos en el terreno filosófico», indica Lombardi, pero tanto él como Altszyler coinciden en que la filosofía está siendo arrinconada por un progreso técnico avasallador.