Todo lo que sucede en el mundo deja huellas en la red, y la masa de datos digitales que genera la humanidad segundo a segundo permite predecir acontecimientos y conductas, hacer negocios o alimentar maquinarias de espionaje e inteligencia. El factor geopolítico y la cuestión de la soberanía.

23 de agosto de 2016

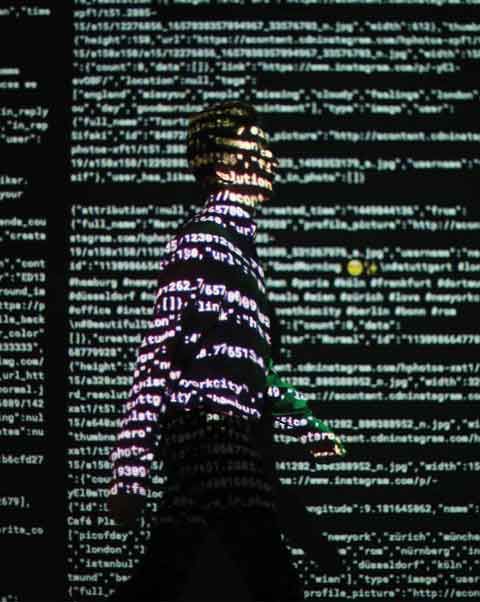

Londres. Una de las obras de la exposición Big Bang Data proyecta un flujo de datos provenientes de Twitter e Instagram. (Getty)

Un ejecutivo de IBM llamado Dave Turek calculó que todo el conocimiento humano generado hasta el año 2003 se podía almacenar digitalizado en cinco exabytes (5.000 millones de gigabytes). En 2011, según el analista, la humanidad producía esa misma cantidad cada dos días gracias a que cada vez más actividades se almacenan en ese formato. Ya no solo producimos libros, películas, planos o inventarios; ahora también generamos fotos, recorridos, mensajes, llamados telefónicos, «me gusta», consumos, temperaturas, movimientos, tráfico y más. A esa masa de información digital se la llama Big Data y a veces se la traduce como «datos masivos». Gracias a nuevas herramientas informáticas, allí se hace visible algo que antes no existía ¿Para qué sirve acumular esas huellas que dejamos en nuestra vida digital?

Correlaciones

En 2009, ingenieros de Google publicaron una investigación en la revista científica Nature donde demostraron el poder de los datos masivos. Por entonces, el buscador recibía cerca de 3.000 millones de consultas diarias, las cuales quedaban almacenadas en sus servidores. Los ingenieros recortaron las provenientes de los Estados Unidos y las cruzaron con estadísticas del sistema de salud sobre casos de gripe estacional de 2003 a 2008. Para ello, usaron un sistema automático que probó 450 millones de algoritmos (es decir, fórmulas matemáticas) hasta que una logró establecer una correlación entre las búsquedas pasadas de la población y la cantidad de casos de gripe diagnosticados por el sistema de salud en ese momento. No se trató solo de una curiosidad estadística: durante las siguientes epidemias de gripe, Google Flu Trends –como se llama el servicio– pudo anticiparle al sistema de salud la cantidad y localización de nuevos casos con solo contabilizar las búsquedas del tipo «remedio para dolor de garganta», «fiebre y estornudos», etcétera, y procesarlas con la fórmula encontrada. ¿Por qué funcionaba ese algoritmo y cuáles eran las búsquedas exactas que daban la clave? No tiene importancia o, en todo caso, es una cuestión a analizar más tarde: lo importante fue demostrar que la correlación existe y permite saber algo que antes resultaba imposible de detectar.

Este es un ejemplo muy claro del poder de los datos masivos o Big data, con mayúsculas. El procesamiento de datos existe desde hace miles de años; hasta en el Imperio Romano hacían censos para conocer la situación poblacional. El problema era recopilar, sistematizar y procesar suficientemente rápido para que los resultados no nacieran ya viejos. Por eso se empezó a trabajar con muestras representativas del universo total algo que, igualmente, tiene un margen de error significativo y grandes costos para ser recopilados. «La comunidad informática siempre corrió detrás del crecimiento de los datos», explica el experto en datos masivos Esteban Feuerstein, doctor en informática de la Universidad de Roma y Director Ejecutivo de la Fundación Sadosky. «Desde que apareció la informática siempre estuvo presionada por necesidades mayores que las posibilidades de procesar: siempre los datos fueron más de los que uno podía abarcar técnicamente». La capacidad de análisis de información creció en los últimos años a tasas tan altas que se produjo no solo un cambio cuantitativo, sino cualitativo en lo que se podía hacer con esos datos. «Se llegó a un punto en el que se pueden almacenar cosas por las dudas, que uno no sabe para qué pueden servir. Esto permitió un nuevo paradigma en el que uno no siempre necesita una hipótesis previa sino que busca correlaciones a ver qué aparece», explica Feuerstein, quien es también Director del Departamento de Computación de la Facultad de Ciencias Exactas y Naturales de la Universidad de Buenos Aires.

Si los datos son suficientes, se pueden encontrar correlaciones inesperadas: Walmart, una cadena con millones de transacciones diarias, analizó qué compraron sus clientes ante alarmas de huracanes y descubrió que, además de linternas y pilas, acopiaban unas galletas dulces llamadas Pop-Tarts. No es fácil saber por qué ocurre eso y en todo caso puede ser materia de una investigación posterior, pero en Walmart se aseguraron de poner las galletas al frente de las góndolas cada vez que había una nueva alarma de tormenta. La cantidad de usos de los datos masivos es infinita y recién está comenzando: «El procesamiento de big data no solo sirve para el marketing. En biología, medicina, genómica, análisis del tránsito, clima… Hay un ejemplo muy lindo de Estados Unidos donde utilizaron big data para la prevención de enfermedades intrahospitalarias», cuenta Feuerstein. «Según las características de cada persona se sabía dónde era mejor operarlo para evitarlas, aunque no se supiera por qué». Amazon, por ejemplo, despidió a sus críticos literarios después de comprobar que sus ventas aumentaban más si dejaba que un algoritmo analizara compras anteriores para hacer nuevas recomendaciones a cada cliente. De la misma manera, el corrector de Google no está hecho por lingüistas, sino por ingenieros que se apoyan en trillones de palabras digitalizadas y de fuentes diversas.

Si bien los bancos guardan y analizan las transacciones electrónicas de sus clientes desde hace años, solo en la última década han comenzado a explotarlas realmente. Ahora las cruzan, por ejemplo, con el clima y así detectan patrones de compra para los días lluviosos y diseñan promociones. También está la posibilidad de colocar sensores en objetos, motores, calles, luminarias para aprovechar cada dispositivo como un nuevo recopilador de datos. El sistema de boleto electrónico SUBE implementado en Argentina agiliza la venta de boletos pero, sobre todo permite conocer a un nivel muy detallado el uso del transporte, horarios pico y viajes promedio. Al cruzarlo con datos de geolocalización puede servir para planificar mejor el transporte, entre otras cosas.

Wall Street. Facebook comenzó a cotizar en bolsa en 2012. Los datos acumulados sobre millones de personas son su principal activo. (Sullivan/Gina/AFP/Dachary)

Empresas que vendían sus servicios para ganar dinero, comprendieron con el tiempo que estaban sentadas sobre datos de sus clientes y comenzaron a aprovecharlos para generar más ingresos: Netflix sabe en tiempo real quiénes miran sus películas, qué edad tienen, dónde viven, sus gustos, horarios, cuántas veces la interrumpen y todo lo que antes requería estudios de mercado costosos y poco precisos. Con esa información fueron capaces de lanzar series como House of Cards, diseñada a gusto de sus clientes. Netflix es prácticamente una recién llegada a un mercado de grandes jugadores establecidos hace décadas, pero como sabe aprovechar los datos y posee un modelo de negocios innovador, pateó el tablero y cambió las reglas. El olfato de un productor sagaz ya no puede compararse con un algoritmo bien alimentado con datos. Lo mismo ocurre en el periodismo, que ya no depende tanto del instinto de un editor, sino de datos precisos sobre qué se lee y cuánto dinero generó por publicidad. ¿Es necesario elegir el color y el ancho del marco de un recuadro en una página web? Utilicemos cuarenta y veamos cuál es el que más se usa. La intuición es el pasado, los datos el futuro.

Vida privada

En la actualidad, los principales recopiladores de información son las redes sociales a las que confiamos gentilmente nuestras amistades, gustos, temas preferidos, estados de ánimo, planes de salir el fin de semana o conversaciones con amigos. Si además usamos la aplicación en un teléfono, podrán saber por dónde nos movemos, con quiénes hablamos, la temperatura del lugar en que nos encontramos, entre otras cosas. Esa información funciona, en primer lugar, como una gigantesca y permanente encuesta que sirve para ubicar publicidades según el perfil del que mira la pantalla. De allí viene la mayor parte de los ingresos de las redes sociales. Como además estas empresas no necesitan producir contenidos para atraer a potenciales clientes, pueden vender publicidad a muy bajo costo; de hecho, aunque no todos lo perciban, se han transformado en competidores feroces por la torta publicitaria para los medios de comunicación tradicionales. Los datos de las redes sociales también sirven para conocer mejor que nadie qué servicio en internet crece, cuál es rentable y decidir la compra de nuevas startup. Estamos entrando en una economía de datos cuya dimensión final es aún difícil de mensurar.

En 2012, Facebook comenzó a cotizar en bolsa. Previamente había publicado un informe financiero en el que declaraba activos por 6.500 millones de dólares. Sin embargo, la tasación de sus acciones sumaba 104.000 millones de dólares, muchos más que IBM, YPF o General Motors. ¿Qué es lo que tiene de valioso? Datos acumulados y millones de personas que mantienen el flujo siempre activo. Su valor relativo varía según su mayor o menor poder adquisitivo. Pero los datos nunca son suficientes: en 2014 la red social del pulgar azul compró por 19.000 millones de dólares a Whatsapp, una empresa relativamente pequeña, sin modelo de negocios rentable, pero que contaba por entonces con 450 millones de usuarios. Acumular datos es como estar sentado sobre una mina: solo hay que descubrir el filón. Empresas cuyo modelo de negocios se basaban en la venta de licencias de uso, cambiaron el eje por otro apoyado en los datos: Microsoft dio tantas facilidades para pasarse a Windows 10 sin pagar porque el nuevo sistema operativo se encarga de recopilar y enviar información a la nube permanentemente. Por otro lado, es tan difícil competir con empresas que acumulan datos permanentemente que la tendencia hacia la concentración y el monopolio es muy grande.

«El nuevo tesoro global es el control sobre el enorme flujo de datos que conectan continentes y civilizaciones, linkeando la comunicación de miles de millones de personas y organizaciones», decía Julian Assange, el creador de Wikileaks, en uno de sus artículos para el diario británico The Guardian. El exespía Edward Snowden brindó detalles sobre las múltiples formas en que las corporaciones comparten información estratégica con los servicios de inteligencia estadounidenses: la frontera entre ambos, aseguran tanto Assange como Snowden, es borrosa. A escala planetaria, conocer los flujos de información en busca de tendencias estadísticas o de datos puntuales permite a las naciones y empresas contar con información muy superior a la de sus competidores.

Cruces y cálculos

«Se crea un problema de soberanía cuando vos cedés grandes volúmenes de datos a otros. Pero en este momento no se ve forma de evitarlo. Lo importante ahora es que también los tengamos nosotros», reconoce Feuerstein. «Se están recolectando datos por todos lados. Nosotros tenemos que desarrollar tecnología e infraestructura a nivel nacional para aprovechar y procesar esos datos. Desde hace tres años en la Fundación vemos que el tema es estratégico. Tiene que ser tratado y manejado a nivel local, no para que no lo hagan los otros sino, para hacerlo nosotros también». Un ejemplo puntual es la iniciativa de la Fundación Sadosky (con el apoyo del Ministerio de Agroindustria) para desarrollar la plataforma «Palenque», donde se concentran todo tipo de datos relacionados con el agro. Sobre esos datos se pueden crear aplicaciones para productores, pymes o investigadores. «Big data trae una serie de problemáticas propias y nuevas. Por ejemplo, la posibilidad de inferir datos privados que antes no aparecían. Si yo sé en qué calle vive y trabaja alguien, puedo cruzar los datos e individualizarlos», explica Feuerstein. «Cuantos más datos tenés, más posible es encontrar relaciones, y uno tiene que pensar en proteger, no solo los datos que recogió, sino también los cruces».

Assange. El control del big data es el nuevo tesoro global, según el creador de Wikileaks. (Hallen/AFP/Dachary)

Las empresas de seguro pueden calcular el riesgo de sus clientes en base a sus notas en el secundario, si tiene hijos o, incluso, sus deportes preferidos. De esa manera puede ofrecer mejores precios a los grupos de menor riesgo, pero ¿es justo que quien tuvo peores notas en la escuela pague más solo por eso? ¿Es estadística o prejuicio? Un profesor de criminología estadounidense, Richard Berk, aprovechó los registros existentes para calcular las posibilidades de que un exconvicto asesinara a alguien. Según él, alcanzó una precisión superior al 75%. ¿Debería un juez basarse en esa información para decidir la libertad condicional de un preso? Como ocurre con todo fenómeno nuevo, la sociedad, las instituciones, los gobiernos deben aprender a lidiar con otros desafíos. En este caso, además, deben hacerlo en un tiempo razonable, antes de que la balanza de los datos se torne imposible de equilibrar.